Александр Цихилов

Блокчейн

Децентрализация управления

Любые системы как совокупности связанных элементов, взаимодействующих между собой, нуждаются в управлении. Причем это касается любых систем – от форм социальной организации различных обществ до аппаратно-программных технологических комплексов. В противном случае их запланированная при проектировании и создании функциональность не гарантирована в силу того, что большинство систем неспособны к эффективной самоорганизации. С этой управленческой проблематикой человеческая цивилизация сталкивалась на протяжении всей своей истории.

Рассматривая различные варианты управления системами, можно в общем виде выделить две его основные формы: централизованную и децентрализованную.

Исторически наиболее ранняя форма управления социумом естественным образом сложилась во времена первобытных людей, когда родовые и племенные группы имели внутри себя строгую управленческую иерархию, но в отношении управления всей популяцией можно было говорить лишь о сугубой децентрализации. Более того, каждая группа в большинстве случаев представляла собой управленческий изолят, поэтому всю совокупную популяцию вида Homo Sapiens сложно представить единой, хотя и децентрализованной системой. Действительно, управленческие связи между группами отсутствовали, а взаимодействие если и имело место, то носило исключительно деструктивный характер. Обычно оно было направлено на уничтожение или в лучшем случае ассимиляцию слабых групп более сильными. По мере развития социальных взаимоотношений между группами у них начали проявляться устойчивые связи, породившие в конечном итоге более сложные иерархические системы с доминирующими элементами во главе. Как только совокупная численность взаимодействующих внутри иерархии групп стала относительно большой, система стала приобретать черты централизованной модели. Иначе говоря, люди создали понятие «государство», во главе которого встал единоличный правитель, выборный или наследственный. Подобная форма государственного устройства оказалась вполне жизнеспособной, поскольку дожила до наших дней, хотя и претерпев различные модификации.

Таким образом, можно констатировать, что вынужденная форма децентрализованного управления социумом на ранних стадиях его становления эволюционировала в более прогрессивный на тот момент централизованный способ. Централизация породила возможность ресурсной консолидации, которая позволила осуществлять проекты на государственном уровне – вести захватнические войны или заниматься масштабным строительством, хотя, впрочем, одно никогда не исключало другого. История таких древних государств, как Вавилон или Египет, – наглядные тому примеры. На первый взгляд, централизация – единственно верный и наиболее эффективный вариант управления системами. Однако уже в средневековый период нашей истории начали появляться и другие управленческие формы. Речь в данном случае не идет об эволюции управленческих принципов, но в некоторых случаях политические обстоятельства просто не позволяли создавать эффективные централизованные управленческие модели.

Хорошим примером является католическая церковь, которая фактически стала, хотя и не без многовековой борьбы, независимым наднациональным институтом в средневековой Европе. И хотя сама внутренняя структура католической церкви была строго иерархичной, а управление в ней в значительной степени централизованным, непосредственные выборы главы церкви были результатом политического консенсуса между великими европейскими державами. Воспоследовавший в эпоху раннего Нового Времени протестантизм и вовсе привнес чистую децентрализацию в организацию новой конфессиональной структуры. Возникла пресвитерианская форма управления церковными общинами в пику традиционному, централизованному епископальному управлению.

Государства также не отставали от прогресса в части организации своего устройства: в 1291 году на карте средневековой Европы появилось по-настоящему децентрализованное государство – Швейцарская Конфедерация – союз нескольких независимых кантонов с фактическим отсутствием центрального управленческого политического института. Сейчас мы можем оценить это давнее событие по достоинству – Швейцария не только не утратила свой суверенитет за века, но и сумела стать одной из самых социально благополучных стран мира. С другой стороны, история знает немало примеров, когда децентрализация в виде феодальной раздробленности государств приводила к их ослаблению, а подчас и гибели.

Эти примеры говорят о неоднозначности утверждения, что одна из форм управления системами лучше другой. Безусловно, у обеих управленческих форм есть свои плюсы и минусы. Попробуем перенести наш анализ от форм социального устройства к технологическим системам. Схожесть социальной и технологической формы управления базируется на общем принципе, который сводится к приложению совокупности управляющих воздействий субъекта на объект. Рассмотрим в качестве технологического примера управление структурой глобальной компьютерной сети интернет. Когда интернет повсеместно вошел в жизнь людей, его стали активно использовать для организации различных сервисов – коммерческих, государственных, социальных. Интересно, что сам по себе интернет – это децентрализованная структура, хотя и имеющая иерархическую природу, особенно на нижних уровнях использования.

Конечный пользователь подключается к сети через своего провайдера, а тот, в свою очередь, если является небольшой организацией, имеет всего лишь один внешний канал к более крупному оператору. Чем крупнее субъект сети, тем больше связей он имеет с другими крупными субъектами, как посредством прямых соединений, так и через пункты обмена сетевым трафиком. Самые крупные операторы сети имеют свою инфраструктуру магистральных каналов по всему миру и обеспечивают наиболее значительную пропускную способность для передаваемых данных. И тем не менее интернет не имеет единой «точки отказа». То есть отключение одного участника системы, пусть даже достаточно крупного, не приведет к остановке работы сети в целом, за исключением того сегмента, который был полностью «замкнут» на выпавший из сети крупный узел. Впрочем, элементы этого сегмента могут в этом случае переключиться на резервные каналы и таким образом вернуться в онлайн.

Именно отсутствие точки отказа и есть одно из главных преимуществ децентрализованных систем. Вернемся к примеру Швейцарии: известно, что федеральный президент или какой-либо иной политический институт этого государства не имеет права отдавать приказ о капитуляции в условиях внешнего военного вторжения. А если такой приказ и будет отдан, то закон категорически запрещает жителям страны его исполнение. Таким образом, агрессору придется иметь дело чуть ли не с каждым швейцарцем по отдельности. То же самое касается и сети интернет. Даже если какая-то страна своим политическим решением захочет отключить интернет, то с большой вероятностью технологически осуществить это намерение будет возможно лишь на своей территории (за исключением узлов, подключенных к интернету по спутниковой связи, при условии, что спутник принадлежит другому государству). Возможно, пострадают пользователи в других странах, магистральные каналы из которых подключены к транзитным узлам страны, решившей отключиться от глобальной сети. Но вся остальная сеть в мире сохранит работоспособность.

Фактически для того, чтобы уничтожить интернет, необходимо отключить почти все его узлы, что само по себе представляет организационную и технологическую сложность, граничащую с практической невозможностью исполнения задуманного. То есть мы можем говорить о теоретической неуязвимости сети, построенной на базе распределенной топологии без единого управляющего центра. Но если мы обратимся на уровень сервисов, построенных на базе сети интернет, то мы увидим, что подавляющее их большинство построено на технологии «клиент – сервер», то есть технологии централизованной.

Все мы давно привыкли пользоваться различными интернет-сервисами. Порталы поддержки сервисов электронной почты, системы облачного хранения данных (например, документов или фотографий), доступ в систему «банк – клиент» для управления своими счетами и совершения платежей, бронирование отелей и авиабилетов, торговые платформы для осуществления сделок на финансовых рынках и многое другое – все эти сервисы построены на базе централизованной инфраструктуры. При использовании каждой такой системы, чтобы получить доступ к ресурсам и услугам, необходимо посетить специальный сайт поставщика конкретной услуги, ввести свой логин и пароль и подключиться к центральному серверу, где хранятся данные клиента или его активы. Однако в случае, если центральный сервер поставщика услуг по какой-то причине отключится, мы не сможем воспользоваться данной услугой, и нам придется ждать, пока сервер восстановит свою работоспособность. В данном случае мы сталкиваемся с главной проблемой централизованных систем – наличием «точки отказа». Отказ в обслуживании может быть результатом действия различных факторов: технологических проблем в виде выхода оборудования из строя, ошибок в программном обеспечении, злоупотреблений внутри структуры самого поставщика услуг, различных внешних хакерских атак или действия компьютерных вирусов. Не последнюю роль могут играть также результаты репрессивного воздействия государственных силовых или регулятивных структур на территории юрисдикции, где физически расположен поставщик услуг.

Все эти факторы, результатом влияния которых становится отказ в обслуживании, заставляют задуматься о том, каким образом можно технологически или организационно избежать подобных ситуаций. Ответом на этот вопрос стало возникновение технологии блокчейн, основанной на построении децентрализованной системы для хранения и обмена данными, что исключает все негативные факторы, естественным образом возникающие при централизации сервисов. На смену сетевой топологии «звезда», лучи которой от всех узлов-пользователей в обязательном порядке сходятся к центральной точке – узлу-серверу, пришла форма организации сети, в которой понятие «центральный сервер» отсутствует как таковое, а все взаимодействие осуществляется между узлами-клиентами напрямую между собой. Такие сети еще называют «одноранговыми» или «пиринговыми». Все узлы в подобной сети в большинстве случаев равноправны, и каждый из них может выполнять как клиентские, так и серверные функции. Подобная децентрализованная топология сети устраняет фактор «точки отказа», повышая степень надежности и работоспособности системы до величин, близких к абсолютным.

Однако у читателей может возникнуть вполне резонный вопрос: если серверы в сети как таковые отсутствуют, то каким образом в подобной системе хранятся общие данные, как они распространяются по сети и каким образом они защищены от несанкционированного доступа или модификации? А также каким образом подобные системы обслуживаются и развиваются, если все участники сети имеют равные права? Технология блокчейн обеспечивает решение большинства из этих вопросов. Данные реплицируются (копируются) между всеми узлами системы. Защиту от изменений или от несанкционированного доступа к данным обеспечивают математические алгоритмы асимметричной криптографии. Вся система функционирует на базе заданного набора правил, с которыми соглашаются все участники системы. В случае если необходимо внести значимые изменения, решение принимается общим голосованием участников системы.

Следует отметить, что администрирование децентрализованных систем на порядок сложнее, чем централизованных. Но это стоит рассматривать как плату за те преимущества, которые дает децентрализация. На текущий момент решены далеко не все проблемы, которые могут возникнуть при управлении децентрализованными системами. И мы еще неоднократно вернемся к обсуждению этой проблематики в последующих главах.

Хеширование информации

Инструмент хеширования данных является важной и неотъемлемой частью технологии блокчейн. Хеширование используется для создания адресации в блокчейн-системах, для формирования цифровой электронной подписи сообщений, а также для добычи криптомонет (так называемого «майнинга») в некоторых блокчейн-проектах, базирующихся на принципе «доказательства работы». Прежде чем рассматривать вышеупомянутые элементы блокчейн-систем, нам потребуется разобраться с тем, что же все-таки такое хеширование данных и на основе каких принципов эта процедура работает.

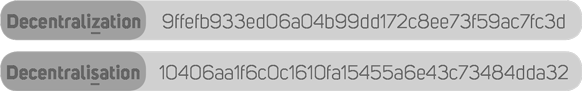

Начнем с определения. Хеширование – это метод преобразования набора данных произвольного размера в стандартизированную строку фиксированной длины при помощи специального алгоритма. То есть если взять какой-то набор данных, например, весь текст этой книги, то можно создать его цифровой отпечаток длиной, скажем, десять символов. При этом мы должны определить точный алгоритм преобразования входных данных и использовать его без изменения для любых других данных произвольного размера, получая на выходе стандартную строку в десять символов. Еще говорят, что в таком случае используется «детерминированный алгоритм», потому что он всегда выдает предопределенный результат. Фактически получаемый результат должен стать уникальным отображением преобразуемых входных данных. Для этого мы должны создать такой алгоритм преобразования, который ни при каких обстоятельствах не допустит получения одинакового результата преобразования для разных входящих наборов данных. То есть не создаст так называемых «коллизий». При этом малейшее изменение во входных данных, даже изменение одного их бита, должно видоизменять результирующий хеш на выходе до неузнаваемости. Вот пример работы одного из самых простых алгоритмов хеширования (SHA-1), где прообразами хешей являются два варианта написания английского слова «децентрализация», при этом во втором слове изменена всего лишь одна буква:

Как видно из полученных результатов, второй хеш не имеет ничего общего с первым, хотя разница в исходных прообразах минимальна. Читатель, вероятно, задастся вопросом: а зачем вообще это все нужно? На самом деле хеширование – это исключительно полезная функция, которая довольно широко применяется в компьютерных технологиях.

Представим себе ситуацию, что нам необходимо передать по каналам связи значительный объем данных, в которых при передаче по тем или иным причинам могут возникать помехи и искажения. Как нам проверить, дошли ли до конечного получателя данные в исходном виде? Пока мы не сравним каждый бит исходной информации с полученным, мы не сможем с уверенностью сказать, что передача данных прошла без ошибок. А что, если по пути следования в данные вмешался кто-то посторонний и намеренно исказил информацию? А как быть, если объем информации измеряется гигабайтами? Процесс сравнения двух огромных информационных блоков может занять значительное время. Не проще ли к передаваемому блоку данных приложить короткий уникальный «цифровой отпечаток», созданный на базе общеизвестного алгоритма хеширования? Тогда при получении мы можем еще раз запустить этот же самый алгоритм, подав ему на вход полученные данные, и затем просто сравнить результирующий хеш с тем, который был приложен к передаваемым данным. Если они в точности совпадут, значит, передача прошла без искажений, и мы имеем на руках данные, полностью аналогичные исходным. Таким образом мы проверяем целостность данных. Популярным вариантом использования алгоритма подобной проверки является получение значения так называемой «контрольной суммы», расчет которой базируется на алгоритме хеширования входного блока данных.

Рассуждая логически, мы приходим к пониманию, что совершенно невозможно преобразовать большой блок данных в исключительно малый без потерь исходной информации. И это действительно так. Алгоритм хеширования представляет собой одностороннюю математическую функцию, результат действия которой практически невозможно обратить в исходные данные до преобразования. То есть вычислительно из хеша чрезвычайно сложно получить его прообраз. Теоретически это возможно осуществить только последовательным перебором вариантов – при помощи так называемого метода «грубой силы». Этот метод базируется на принципе «зашифруй и сравни»: некие предполагаемые исходные данные хешируются и сравниваются с имеющимся хешем. Если эти два хеша не совпали, значит, данный предполагаемый прообраз нам не подходит. Меняем его и хешируем снова – и так далее до бесконечности, пока хеши вдруг неожиданно не совпадут. Только тогда мы можем говорить о том, что мы «расшифровали хеш», но количество вариантов, которое нам необходимо перебрать, чтобы добиться такого результата, измеряется, без преувеличения, астрономическими величинами.

Данный метод, кстати, широко используется для защиты хранимых секретных паролей на различных серверах. Размещать пароли пользователей на интернет-серверах в открытом виде явно небезопасно – их могут похитить злоумышленники и затем попытаться нанести системе и ее участникам материальный ущерб. Но если пароли хранятся не в открытом виде, а в виде хешей, то задача несанкционированного доступа значительно усложняется. Если пароль вводит его владелец, то система хеширует пароль и сравнивает с хранимым хешем пароля для данного пользователя. Если они совпали, значит, пароль введен верный, и система открывает пользователю доступ. Если хеши не совпадают – пароль неправильный. А наличие у злоумышленника украденного хеша пароля задачу ему отнюдь не упрощает, поскольку ему необходимо восстановить исходный пароль методом масштабного перебора вариантов. Понятно, что чем длиннее исходный пароль, тем больше максимально возможных вариантов его перебора. Поэтому для получения исходного пароля необходимо задействовать исключительные вычислительные мощности, что в конечном итоге отражается на общей стоимости атаки, которая может обойтись дороже, чем возможная материальная выгода от подбора конкретного пароля.

Еще один популярный способ использования алгоритмов хеширования применяется в так называемых торрент-трекерах. Торренты – это технология обмена файлами, как правило, медийного характера (в подавляющем большинстве – видео). Сама технология имеет гибридную модель, когда торрент-файлы, содержащие техническую информацию, распространяются централизованно через специальные торрент-трекинговые порталы. При этом непосредственный обмен основными файлами происходит децентрализованно, через организацию прямого соединения между «сидерами» – теми, кто отдает файлы, и «личерами» – теми, кто их получает. В силу объема передаваемой по сети интернет информации (а иные видеофайлы могут иметь объем, измеряемый гигабайтами) их передача осуществляется фрагментами. Задача принимающей стороны – связаться с различными отправителями фрагментов одного и того же файла и получить на свое устройство все его части.

Конечная цель – собрать в правильном порядке из этих кусочков исходный файл большого объема так, чтобы целостность всех данных не пострадала и медийный проигрыватель не выдал ошибку при попытке запустить файл для просмотра. Одна из основных процедур данной технологии – постоянное сравнение значительных блоков данных с целью контроля их целостности и правильной идентификации их фрагментов. Вот здесь на помощь и приходит функционал хеширования. Именно по хешам как целых файлов, так и их фрагментов осуществляется идентификация соответствия блоков данных именно тем, которые были запрошены. И если все хеши совпадают, значит, в итоге мы гарантированно «склеим» нужный нам файл без ошибок. Поэтому именно технология хеширования позволяет быстро и надежно сравнивать различные блоки данных и гарантировать их целостность при передаче.

Наконец, технология хеширования активно используется для ускорения поиска данных. Для этого формируются так называемые «хеш-таблицы», которые содержат хеши различных информационных блоков. Их сортируют в определенном порядке, чтобы при осуществлении поиска можно было быстро найти данные по их хешам, обращаясь сразу в нужный раздел вместо масштабного поиска по всей базе.

Теперь рассмотрим вопрос, какие математические и логические операции используются для вычисления хешей. Алгоритмов хеширования достаточно много – от относительно простых до достаточно затейливых. Обычно при создании математической модели алгоритма преследуются цели усложнения задачи обратного восстановления прообраза из хеша и расширения максимально возможного диапазона получаемых из прообраза хешей. Это необходимо для того, чтобы вероятность появления коллизий, то есть получения одинаковых хешей из двух различных прообразов, составила исключительно малую величину. Понятно, что с увеличением разрядности (размера) хеша вероятность появления коллизий экспоненциально уменьшается. Однако в ряде случаев требуется решить задачу для хешей относительно небольших размеров, поскольку это влияет на совокупный объем хранимой информации и, как следствие, на стоимость этого хранения.

В качестве примера работы алгоритмов хеширования приведем несколько наиболее популярных процедур, в том числе и тех, которые используются в различных проектах, базирующихся на технологии блокчейн – таких, как, например, Bitcoin (SHA-256) или Ethereum (SHA-3). Данные алгоритмы состоят из определенного количества шагов (итераций), на каждом из которых с данными совершаются какие-либо логические операции из следующего набора.

● «Конкатенация» (то есть «сцепление» или «склеивание» двух блоков данных, когда второй становится продолжением первого, например, конкатенация «1111» и «2222» дает результат «11112222»).

● «Сложение» (обычное арифметическое действие для двух и более чисел).

● «Конъюнкция», или «Логическое И», «AND» (результат этой побитовой операции будет истинным (1), если оба бита являются единицами, в противном случае результат будет ложным (0)).

● «Дизъюнкция», или «Логическое ИЛИ», «OR» (результат этой операции будет истинным (1), если хотя бы один из аргументов является истинным (1), в противном случае результат будет ложным (0)).

● «Логическое Исключающее ИЛИ», «XOR» (результат этой операции для двух бит будет истинным (1), только если один из аргументов будет истинным (1), а второй ложным (0), в противном случае результат будет ложным (0)).

● «Логическое отрицание», «NOT» (побитовая инверсия, результат унарной операции, где результирующий бит всегда будет противоположен по значению входящему биту, то есть единицы становятся нулями и наоборот).

● «Побитовые сдвиги» (когда значения битов перемещаются в соседние регистры по направлению сдвига, например, для блока «10100110» результатом логического сдвига влево будет «01001100»).

Побитовые сдвиги могут быть логическими (когда последний бит по направлению сдвига теряется, а первый становится нулем) и циклическими (когда последний бит по направлению становится на место первого). В приведенном выше примере рассматривается именно логический сдвиг, поскольку результат циклического сдвига влево в данном случае представлял бы из себя результат «01001101». Кроме того, внутри каждой итерации могут применяться наборы вспомогательных констант, закрепленные за каждым из алгоритмов. Эти константы используются в различных операциях, описанных выше. Таким образом, с каждым шагом алгоритма результат все больше отдаляется от исходных данных. Происходит сложное циклическое «перемешивание» данных – возможно, именно поэтому эту процедуру и назвали «хеширование», что в переводе с английского означает «мешанина» и часто относится к блюдам из мелко порубленного мяса или овощей. Ингредиенты подобных блюд, как и результат хеширования, невозможно привести к исходному виду (прообразу). Однако попытки поиска эффективных методов восстановления прообразов для различных хеширующих алгоритмов существовали с самого начала их появления.

Для того чтобы представить себе проблематику, связанную с криптостойкостью самых популярных алгоритмов хеширования, оценим рассчитанные показатели многообразия вариантов хешей и вероятностей нахождения коллизий для них. Соотношение между разрядностью (размером) хеша n и числом возможных выходов (вариантов генераций хеша) равно 2 в степени n. Если средняя длина хеша в основных популярных блокчейн-проектах составляет 256 бит, это означает число выходов, равное 2256 или примерно 1,2 × 1077, то есть значению, сопоставимому с оценкой числа атомов в наблюдаемой Вселенной. Однако чтобы найти коллизию, необязательно перебирать все варианты.

Существует известный алгоритм атаки – так называемая «атака дней рождения», которая базируется на парадоксе, связанном с решением задачи о вероятности совпадений дней рождения хотя бы у двух человек в группе, состоящей из N людей. Парадокс состоит в том, что оценивается не вероятность того, что у какого-то конкретно выбранного человека в группе с кем-то совпадает день рождения (эта вероятность для небольших групп достаточно мала), а вероятность совпадения дней рождения у любой пары людей из данной группы. А это уже совсем другой порядок вероятности. Например, для группы из 23 людей такая вероятность превышает 50 %, а для 60 человек и более вероятность становится больше 99 %. С коллизиями в алгоритмах хеширования также можно провести аналогию, но базируясь на гораздо больших числовых значениях. Однако общий смысл от этого не меняется: для того, чтобы найти коллизию с какой-то значимой величиной вероятности, нужно перебрать гораздо меньшее число вариантов, чем максимальное число возможных выходов. Для ключа в 256 бит и вероятности нахождения коллизии в 75 % это значение составляет 5,7 × 1038, что на 39 порядков меньше максимального математически возможного числа выходов. Как видите, даже подобная существенно меньшая величина вероятности все равно поддерживает сложность задачи перебора вариантов на исключительно высоком вычислительном уровне. Поэтому в блокчейн-технологиях используются алгоритмы хеширования с высокой разрядностью, чтобы защитить хранимые данные от посягательств злоумышленников как минимум до того момента, пока вычислительные мощности не позволят преодолеть эти барьеры сложности.

Мы постарались рассмотреть основные моменты, которые необходимо знать о принципах хеширования. К непосредственным применениям этой процедуры мы еще вернемся в специальных разделах книги, посвященных практическим реализациям блокчейн-проектов.